2022年以来,随着谷歌、百度、Meta、微软等国内外企业先后推出自己的AI绘画模型或者平台,AIGC这一新型内容创作形式,获得了越来越多的关注。

在今年7月的百度世界大会上,百度创始人李彦宏曾表示:“AIGC或许将颠覆现有内容生产模式,实现以‘十分之一的成本’,以百倍千倍的生产速度,去生成AI原创内容。”

事实上,百度正通过AI大模型的能力,来实现李彦宏畅想的这一图景。

在今天的百度“AIGC智能创作新风尚”媒体沟通会上,百度技术委员会主席吴华就分享了百度AIGC内容生成能力背后的技术原理,并针对目前火热的“智能创作”介绍了百度打造的三位能力超群的“天才创作者”。

吴华指出,熟练掌握AIGC,创作者将能够更加轻松、高效、快乐地创作,甚至一个人就可以完成编剧、美术创作及后期剪辑等内容创作全流程工作,成为天才创作者。

吴华眼中这三位能力超群的百度“天才创作者”都身怀哪些绝技呢?作为人类创作者,要如何借助“天才”的能力,来丰富、提效自身创作?

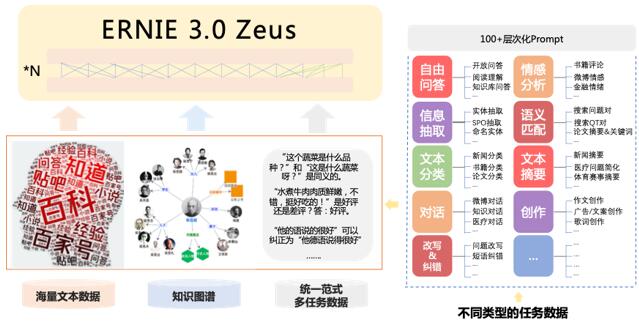

2022年5月,百度发布了融合任务相关知识的千亿大模型ERNIE 3.0 ZeUS。该模型能够从丰富多样的无标注数据中学习,同时在学习过程中融入知识图谱指导模型学习世界知识和语言知识,进而提升学习的效率。此外,该模型还能从摘要、对联、翻译、分类、阅读理解等百余种不同形式的任务中学习知识,通过对通用知识和专门知识的学习来提升模型泛化能力,使得ERNIE 3.0 ZeUS能够做到多种语言理解和生成任务,成为名副其实的“通才”。

例如,输入一篇论文,ERNIE 3.0 ZeUS可以立刻自动生成摘要;输入一个题目,它可以瞬间写出上百篇作文,而且作文还可以结合语境,写出不同的风格,甚至是诸如诗歌、小说等不同的体裁内容。

同样的,ERNIE 3.0 ZeUS也会写剧本。

吴华指出,很多电视剧的剧本并不是由一位编剧单独完成的,而是由一位总编剧制定总纲,再制定每一集的大概内容,再交给多位编剧分别写每集的具体对话、详细故事。因此,如果一个人能编制一部电视剧的总纲,他便可以把每一集的要求交给ERNIE 3.0 ZeUS生成故事,然后再经过合并整理最终写出整部剧。

吴华介绍,文心 ERNIE 3.0 系列模型已经在几十类自然语言理解和生成公开权威任务,以及零样本、小样本学习任务上处于世界领先水平。此外,它还发布了业界首个开放的千亿参数中文生成API,供各行各业开发者到文心大模型官网上调用、学习。

目前,普通用户可以通过百度飞桨旸谷社区在线体验 ERNIE 3.0 ZeUS 的文本理解和文本创作能力,同时,ERNIE 3.0 ZeUS 也提供 API 体验调用入口,供开发者使用。

在编剧的工作完成后,场景和画面的美术创作,以及视频内容的产出和后期剪辑,是影视创作中必不可少的关键环节。借助百度文心ERNIE-ViLG 2.0以及VIMER-TCIR等模型工具,创作者可以逐步完成他想要实现的目标。

2022年10月,百度发布了业界首个知识增强的AI作画大模型 ERNIE-ViLG 2.0。它能根据一句话或者一段描述文本,生成一幅精美的画作。吴华介绍指出,为提高文本生成图像的准确性,百度在AI预训练学习过程中创新性地提出了知识增强的扩散模型,实现了精准的细粒度语义控制;同时通过引入混合降噪专家网络,对图像生成不同阶段对模型、计算性能要求的不同,使用不同网络进行了针对性地建模和优化,进而提升了图像生成的质量。

吴华指出,在实际应用场景下,只需要输入一段文字,ERNIE-ViLG就可以快速理解这段文字所表达的含义和场景,然后根据这个理解,几十秒内就可以生成媲美人类作画水平的图像,而且可以同时生成数百张风格各异的画作,比如写实、意象、中国风、二次元等等。它甚至可以生成现实世界中没有创造性的图像,比如穿西装的齐天大圣、街边撸串儿的熊猫,让人们天马行空的想象力得到精准的可视化呈现。

文心 ERNIE-ViLG 2.0 可广泛应用于工业设计、动漫设计、游戏制作、摄影艺术等场景,激发设计者创作灵感,提升内容生产的效率。

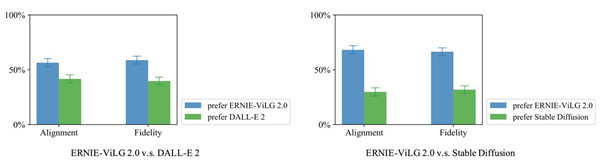

据介绍,在权威公开数据集 MS-COCO 上,目前ERNIE-ViLG 2.0已经刷新 SOTA 效果,性能远远超过了国际上的同类技术;而在图文相关性和图像保真度两个维度的人工评估上,ERNIE-ViLG 2.0 相对 DALL-E 2 和 Stable DiFFUSion 同样取得了较大的优势。

目前,面向普通用户,百度以文心ERNIE-ViLG 2.0大模型为底座推出了“文心一格”产品,用户只需输入一段自己的创想文字,并选择期望的画作风格,即刻可以生成创意精美的画作。

由于人类眼睛的特殊生理结构,如果所看画面的帧率高于60Hz时,就会认为是连贯的,这也造就了早期电影胶片是一格一格拍摄出来,然后再快速播放的情况。而AI生成的图像,在经过帧率的调控之后,也将进一步生成视频。

据吴华介绍,在视觉内容生成方面,百度在文生图扩散模型的基础上加入时序建模,使得模型能根据文本或者图像生成新的视频。创作者可以根据用户提供的一段描述文本,或者一幅图像,自动地生成高清、流畅的视频。

此外,通过百度研发的VIMER-TCIR多任务大模型,还可以实现对生成视频的修复和编辑,通过画质提升、边缘锐化等方式增强视频的清晰度,达到全方位提升视频编辑效率和观感体验。据悉,TCIR模型已在去噪、增强、去模糊等多个任务领域达到SOTA结果,并在AIM2022压缩图像超分竞赛中,以大幅度领先优势取得冠军。

目前,VIMER-TCIR多任务大模型也已经在老电影修复等场景实现落地,大幅提升了效率,每天单机可修复视频28.5万帧,解决了绝大部分画面的修复问题。

吴华强调,一系列AIGC生产工具的出现,大幅度提高了音视频等内容创作者的工作效率。AIGC正让个体创作者成为真正的“独立”制作人。