面向公众的人工智能工具,包括ChatGPT等基于文本的应用程序,或文本到图像的模型——如Stable Diffusion、Midjourney或dall – e2等,已迅速成为监管、法律和在线隐私问题方面的最新数字前沿。恶意行为者已经在生成性人工智能的能力帮助下实施刑事犯罪,并传播错误和虚假信息,各国政府正在努力跟上步伐,而公司则将责任推给个人用户。正如毕马威澳大利亚公司(KPMG Australia)和昆士兰大学(University of Queensland)进行的一项调查显示,一般公众已经不相信政府机构会监督人工智能的实施。

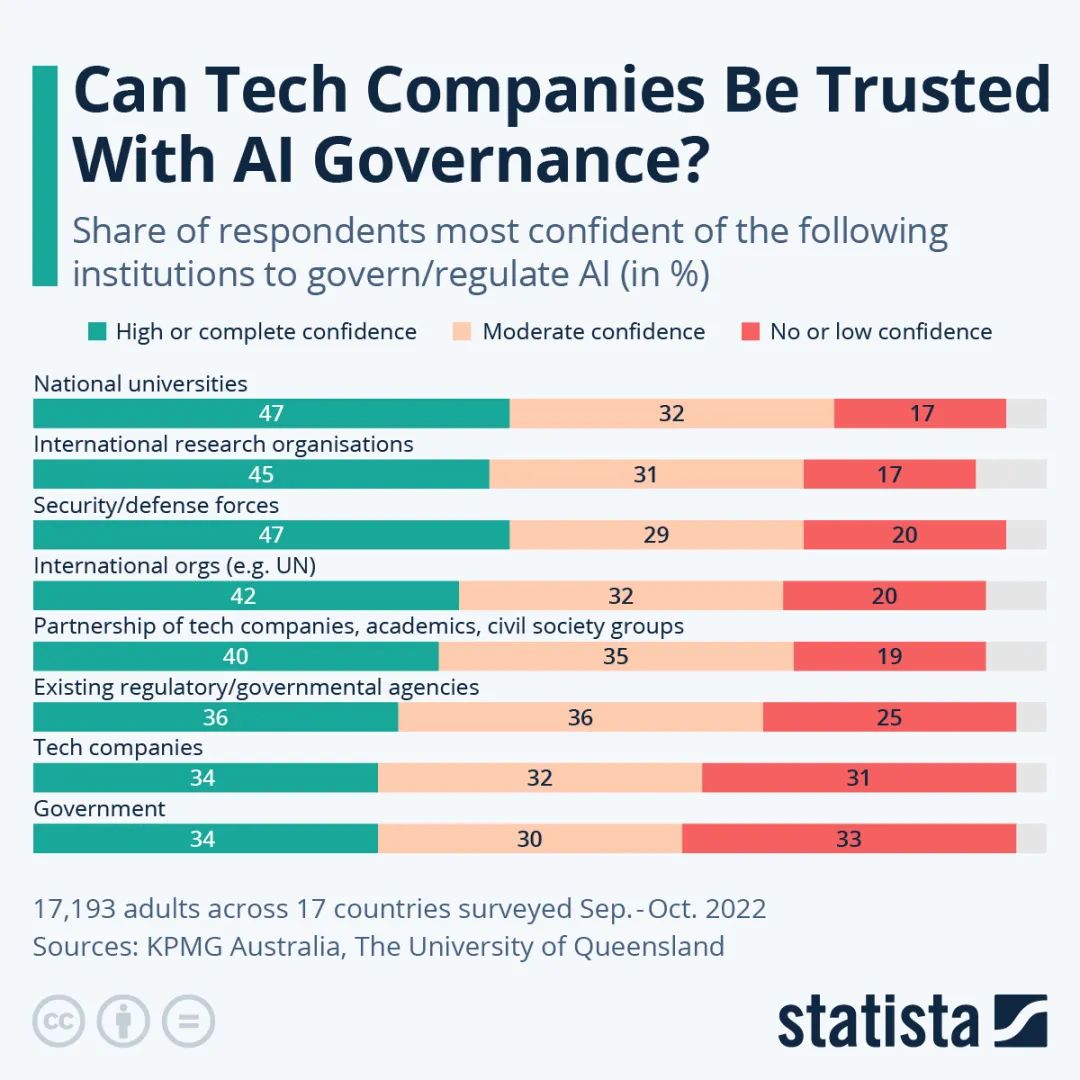

该研究对17个国家的1.7万多人进行了调查,发现只有三分之一的受访者对政府在人工智能工具和系统的监管和治理方面具有高度或完全的信心。调查参与者同样对科技公司和现有监管机构作为人工智能的管理机构持怀疑态度。

尽管被调查者对国家政府表现出怀疑态度,但人们对像联合国这样的超国家机构的看法是比较积极的。欧盟委员会目前是这类机构中唯一起草了旨在遏制人工智能影响并确保保护个人权利的法律的机构。《人工智能法案》(AI Act)于2021年4月提出,目前尚未通过。拟议的法案将人工智能应用分为不同的风险类别。例如,旨在操纵公众舆论或从儿童或弱势群体身上获利的人工智能在欧盟将成为非法行为。像生物识别数据软件这样的高风险应用程序将受到严格的法律限制。专家们批评该政策草案存在明显的漏洞和模糊的定义。