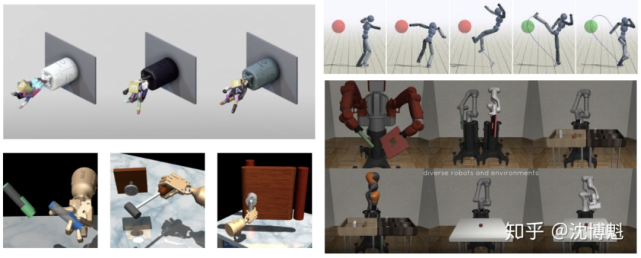

在这项研究中,斯坦福视觉与学习实验室(SVL)Silvio / 李飞飞组的研究者推出了一个全新的模拟环境 iGibson,从而可以为大型真实场景中的交互任务开发机器人解决方案。iGibson 包含 15 个充分可交互、视觉上逼真、依据真实房屋构建的场景,并且可以支持 CuBICasa5K 和 3D-FRont 的 8000 余个场景。真正实现了「可交互性」。

近来,面向 AI 和机器人的模拟环境得到了大力发展。机器人模拟环境在各大学术会议中变得普遍。模拟环境有助于机器人领域的发展。

机器学习导致了对数据的需求增长,而在现实世界中收集数据变得不现实。模拟环境降低了机器人研究的准入门槛。

模拟环境为机器人任务提供了可复现的基准,有助于不同方法的比较。

斯坦福视觉与学习实验室(SVL)的研究者开发了 iGibson 以用来训练和测试可交互的AI智能体。

物理引擎和模拟环境在任务解决中发挥不同的作用。iGibson 的研究聚焦于机器人在大型真实场景中的交互任务。

论文链接:https://aRxiv.oRg/pdf/2012.02924.pdf

15 个充分可交互、视觉上逼真、依据真实房屋构建的场景。其中所有物体可真实交互,包含了材料与动力学信息;

可支持 CuBICasa5K的 8000 余个场景。

真实的传感器信号模拟,包括:RGB (基于物理渲染引擎(PhYsics-based RendeReR)),深度图,1 束或 16 束的激光雷达,语义 / 实例 / 材料分割图,光流,场景流等;

内置运动规划算法,用于规划机器人底座的移动(在环境中导航)与机械臂的移动(抓取操纵物体)。

内置域随机化功能,可随机替换 visual textuRes (视觉图像)、材料与动力学信息、物体实例。由此,我们可以产生出无穷无尽的随机环境用于训练与测试。

人机交互系统,可为机器人提供人工示范。

我们认为模拟环境有极大的潜力来帮助研究人员解决机器人与 AI 的各种问题。iGibson 是一个完全开源的、面向大型场景交互任务的模拟环境。我们真心希望 iGibson 能为机器人与 AI 的研究做出贡献。