人工智能正在各行各业的企业中迅速部署,预计企业在未来三年内将在人工智能系统上的支出增加一倍。但是,AI并不是最容易部署的技术,即使功能齐全的AI系统也可能带来业务和客户风险。

近期在信贷、招聘和医疗保健应用中有关AI的新闻报道中强调的主要风险之一是存在潜在的偏见。因此,其中一些公司受到政府机构的监管,以确保其AI模型是公平的。

机器学习模型在实际示例中进行训练,以模仿未见数据的历史结果。训练数据可能由于多种原因而产生偏见,包括代表受保护群体的数据项数量有限以及在整理数据过程中人为偏见潜伏的可能性。不幸的是,对有偏见的数据进行训练的模型通常会使他们做出的决策中的偏见永存。

确保业务流程的公平性不是一个新的范例。例如,美国政府在1970年代禁止通过公平贷款法(例如《平等信贷机会法》(ECOA)和《公平住房法》(FHAct))对信贷和房地产交易进行歧视。此外,《同酬法》、《民权法》、《康复法》、《就业年龄歧视法》和《移民改革法》都提供了广泛的保护措施,以防止歧视某些受保护群体。

构建公平的AI需要两步过程:理解偏见和解决潜在偏差。在本文中,我们将重点讨论第一个主题。

了解偏见

在解决问题之前,您需要首先确定其存在。没有一家公司会以恶意的意图将其AI系统偏向用户。取而代之的是,由于模型开发生命周期中缺乏意识和透明性,导致了无意间引入了偏见。

以下列出了最佳实践,以更好地理解和减少ML开发生命周期中的偏见。

获得主要利益相关者的支持

不公平的系统类似于会产生重大业务影响的安全风险。实施公平治理流程需要物质资源。没有领导团队的支持,必要的实现该流程所需的任务可能无法获得超过其他业务优先级的足够开发能力。因此,强大的以公平为中心的AI流程始于AI所有利益相关者的认同系统,包括管理团队。

任命“内部捍卫者&Rdquo;

确保买入后,任命负责建立公平程序的冠军。倡导者在包括法律和合规代表在内的各个团队之间进行沟通,以草拟与公司领域(例如,医疗保健、招聘等)和团队的特定用例(例如,建议重新住院、确定保险费、评估信用度)相关的准则等。有几种偏见度量标准,例如机会均等、人口统计均等。公平性度量标准的选择取决于用例,并由从业者掌握。

在最终确定指导方针之后,“捍卫者&Rdquo;将对相关团队进行培训。为了使其可行,AI公平工作流程可确保数据和模型偏差。另外,它要求访问被评估公平性的受保护属性,例如性别和种族。在大多数情况下,很难收集受保护的属性,在大多数情况下,直接在模型中使用它们是非法的。

但是,即使未将受保护的属性用作模型功能,也可能存在代理偏差,另一个数据字段(如邮政编码)可能会与受保护的属性(如种族)相关联。如果没有保护属性并对其进行衡量,则很难识别偏差。团队解决这一差距的一种方法是推断受保护的属性,例如在贷款承保模型的情况下使用普查数据推断性别和种族。

测量偏差

接下来,我们需要测量偏差。不幸的是,许多类型的机器学习模型固有的不透明性使得测量其偏差变得困难。人工智能的可解释性是一项最新的研究进展,它解锁了人工智能的黑匣子,使人们可以了解人工智能模型内部发生的事情。这导致对偏差的透明评估,以确保由AI驱动的决策是负责任和可信赖的。

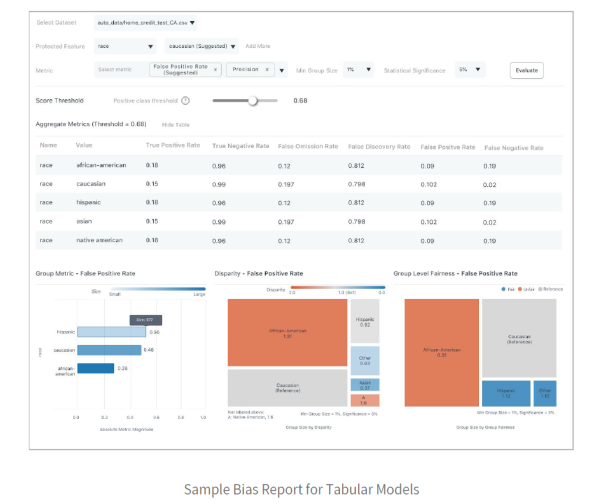

以下是ML模型的公平报告示例:

该特定报告是用于评估风险以做出贷款决策的模型。它在受保护的“种族&Rdquo;属性上具有其他元数据。使用此报告,用户可以使用各种公平性指标来查看组公平性和不同的影响。建议您根据用例的领域需求,专注于特定指标(例如,“误报率&Rdquo;)和特定特权类别(例如,白种人)来衡量偏见。

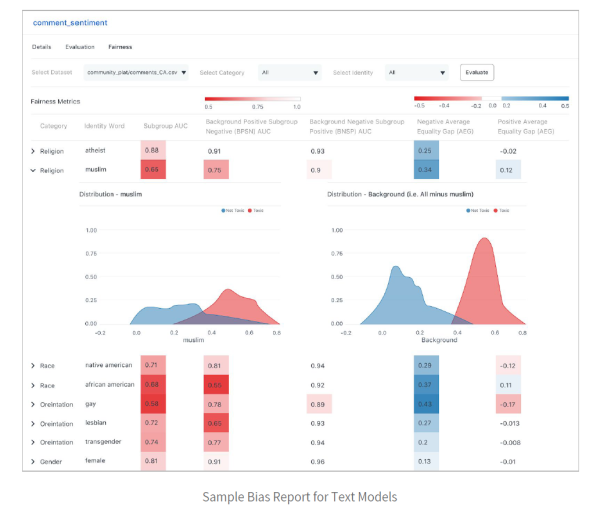

除了上面的贷款模型之类的表格模型外,文本和图像模型中也会出现偏差。例如,下图显示了一个文本模型,该文本模型正在测量用户生成的注释的毒性。

下面的样本偏见报告显示了该模型如何评估跨种族和宗教阶层的毒性。

请注意,热图如何表明该模型相对于“女性&Rdquo;和“无神论者&Rdquo;身份群体的偏见要小得多。在这种情况下,ML开发人员可能希望将有偏见的身份组的更多代表性示例添加到训练集中。

生产模型的公平考虑

无论在部署之前是否存在偏差,一旦模型为实时流量提供服务,就有可能发生偏差。偏差的变化通常是由于向部署的模型提供了输入数据而导致的,这些输入数据在统计上不同于用于训练模型的数据。因此,最佳实践是在部署后监视模型中的相关偏差指标。下面的屏幕截图描绘了监视模型准确性指标(用于跟踪潜在偏差的相关指标之一)的外观。

总之,人工智能为量化和解决迄今为止由人主导和不透明的决策系统中的偏差提供了独特的机会。