行至2024,云端大模型还未分出胜负,端侧模型早已硝烟四起。

去年上半年,谷歌以可在移动设备上离线运行的PaLM2轻量级选手“壁虎”打响了端侧模型第一枪,到了年底,端侧模型时代的大幕就被缓缓拉起。

法国创企MistRal AI率先发布MixtRal 8x7B模型,微软更是半年时间加速跑,从27亿参数的PHi-2到SLM(小语言模型)PHi-3系列,以“便宜得多,但响应能力接近比它大10倍的模型”强调高性价比。

Google携带GeMMa模型向Meta的LlaMa-2大模型发起挑战,苹果也以“小模型”家族宣告离“让人工智能在苹果设备上本地运行”目标更近一步。

而大洋彼岸的另一侧,在中国上海张江,也有这么一家通用大模型厂商,驶上了端侧模型的快车道,以类脑分区激活的工作机制、改进反向传播算法逐步实现“同步学习”,并在走通多模态上率先“卷”入。

这,就是岩芯数智CEO刘凡平带队的RockAI。

事实上,今年1月,RockAI发布的国内首个非Attention机制的通用自然语言大模型——Yan1.0模型,就标志走向设备端的第一步。

当时这一模型100%支持私有化部署应用,不经裁剪和压缩即可在主流消费级CPU等端侧设备上无损运行,在研究人员现场对Yan 1.0模型在Mac笔记本上的运行推理展示中,刘凡平也画出了接下来将在更加便携的设备或终端中进行无损部署的蓝图。

而现在,随着Yan 1.0迈入1.2阶段,“在树莓派上率先跑通”把其在更低端设备的无损适配从预期变为了现实。

图为Yan架构模型在树莓派上运行

树莓派系列作为全球最为知名的袖珍型小巧却又性能强大的微型电脑,可广泛应用于物联网、工业自动化、智慧农业、新能源、智能家居等场景及设备,譬如门禁、机器人等终端,但它虽具备所有PC的基本功能,却是算力最低的设备代表。

同时,树莓派大部分情况没有联网,这就意味着,跑通树莓派,等同于打开了低算力设备端的大门以及不联网的多场景应用。

不过,机遇之大,挑战亦不小,不少大模型玩家都屈身于“有损压缩”。

就连4月网友发现能在树莓派5以每秒1.89个Token的速度运行,支持8K上下文窗口的LlaMa3 8B ,也是采用把模型量化裁剪后压到极致的方式。

而这就如同把平铺的纸揉小后放入,会导致纸张有褶皱般,让多模态下的性能损失无法恢复到原有状态去进行模型训练,同时也伴随着卡住不动、死机等不确定情况发生。

此时,原生无损放入的重要性就凸显,而这正是RockAI基于底层技术做“破坏式”创新的优势所在。

不同于传统TRansfoRMeR模型自带算力消耗和幻觉等问题,Yan架构为低算力设备运行而生,1.0版就以百亿级参数媲美千亿参数大模型的性能效果,以记忆能力提升3倍、训练效率提升7倍的同时,实现推理吞吐量的5倍提升,实现云端运行的高性价比。

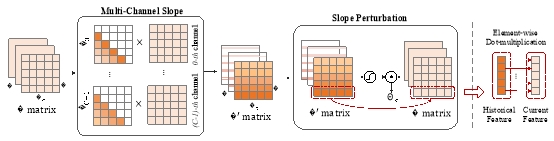

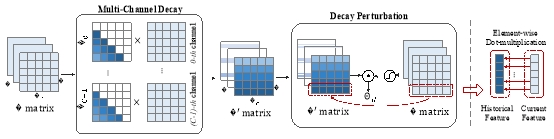

图为Yan架构模型的关键模块MCSD Block,引自Yan架构论文: 《MCSD: An EFFicient Language Model wITh DiveRse FUSion》

对比数据表明,在单张4090 24G显卡上,当模型输出Token的长度超出2600时,TRansfoRMeR的模型会出现显存不足,而Yan模型的显存使用始终稳定在14G左右,理论上能够实现无限长度的推理。

再到让通用大模型去兼容更多的设备,实现更多个性化的设备端应用,则让RockAI在同模型架构下,可水到渠成地“为设备而生”。

那么,对于树莓派这一门槛,RockAI是如何破局的呢?答案就在技术创新上。

自创业之初,刘凡平就一直在思考“大模型动辄上万亿的Token训练是否真的必要”,以人类大脑几十亿的训练量来看,他判断,数据、算力并不是最终的瓶颈,架构、算法才是重要的影响因素。

故而在跑通树莓派的路上,基于全新自研的Yan架构,RockAI在实验室对人工神经网络最底层的反向传播算法进行挑战,寻找反向传播的更优解尝试。

而在算法侧,RockAI更是在上半年率先有所突破,在人脑神经元分区激活的启发下,实现了类脑分区激活的工作机制。

如同人开车跟写字会分别激活脑部的视觉区域和阅读区域一般,Yan 1.2也不再需要全量的参数去训练,会根据学习的类型和知识的范围来决定只调整哪部分神经元,而这种分区的激活方式不仅可以减少数据训练量,同时也能有效发挥多模态的潜力,该算法被RockAI称作基于仿生神经元驱动的选择算法。

数据表明,人脑的神经元大概是800-1000亿,功耗大概是20-30瓦,而一台GPU算力服务器功耗能到2000瓦,这就意味着主流大模型的全参数激活,本身就是不必要的大功耗浪费。

在今年3月类脑分区激活的工作机制实现后,甚至10亿级参数的Yan模型通过改进在0压缩和0裁剪的情况下在一台7年前生产的Mac笔记本的CPU上跑通。

2个月后,“原生无损”跑通树莓派的故事便在RockAI如期而至。

跑通树莓派,是RockAI走通低端设备上的里程碑,同时也预示着距离其“同步学习”概念落地更近了一步。

众所周知,TRansfoRMeR大模型带来一种开发范式——先通过预训练让大模型具备一定的基本能力,然后在下游任务中通过微调对齐,激发模型举一反三的能力。

但这样的云端大模型虽好,在实践中却有着不能实时改进和学习的问题。

TRansfoRMeR架构在大参数大数据的情况下,想在预训练完成之后再大规模的反向更新代价极其大的,尤其对算力要求非常高,更别提返到原厂去重新训练的时间和经济成本。

也就导致在严谨内容场景下,一旦有内容和评价发生较大转变,TRansfoRMeR大模型学徒们往往要1-2个月去把数据清掉后,再重新训练后进行提交,客户一般很难接受。

这些toB实践中的真实反馈,让刘凡平意识到客户对模型立即更新的需求,这要求模型不仅具备实时学习的能力,同时学习之后不能胡说八道。

怀揣着“机器能否具有像人一样实时学习的能力”的思考,以及跟着客户真实需求走的大方向指引,同步学习这一解法,在RockAI逐步清晰。

相比较泛机器学习领域的实时学习和在线学习、增量学习等概念,刘凡平认为RockAI首创的同步学习概念差异性在于,做知识更新和学习时在模型层面训练和推理同步进行,以期实时、有效且持续性地提升大模型的智能智力,应对各类个性化场景中出现的问题。

而要理解快速更新的问题,涉及到现在神经网络的底层原理,本质上神经网络的训练是前向传播和反向传播的过程。

就如同你正在玩一个猜数字游戏,你需要猜出一个1到100之间的随机数。在开始时,你没有关于这个数字的任何信息,所以你的第一次猜测可能是基于直觉或是随便选了一个数,比如50。这就好比是神经网络中的前向传播——在没有任何历史数据的情况下,根据当前的参数(权重和偏置)进行一次预测。

当你猜测了50后,游戏会告诉你这个数字“太大”或“太小”。如果你听到“太大”,那么下一次猜测时,你会选择小于50的一个数;如果得到反馈是“太小”,你则会选择一个大于50的数。

这就类似于反向传播对参数的调节过程。只要模型调整足够快、代价足够小,就能更快达到预期,实现从感知到认知再到决策这一循环的加速,对现有知识体系进行快速更新。

为此,RockAI给出的同步学习解法落在,不断尝试寻找反向传播的更优解,试图能更低代价更新神经网络,同时以模型分区激活降低功耗和实现部分更新,从而使得大模型可以给到客户后持续成长,像人类学习一样建立自己独有的知识体系。

跑通树莓派,是RockAI走通低端设备上的里程碑,同时也预示着距离其“同步学习”概念落地更近了一步。

众所周知,TRansfoRMeR大模型带来一种开发范式——先通过预训练让大模型具备一定的基本能力,然后在下游任务中通过微调对齐,激发模型举一反三的能力。

但这样的云端大模型虽好,在实践中却有着不能实时改进和学习的问题。

TRansfoRMeR架构在大参数大数据的情况下,想在预训练完成之后再大规模的反向更新代价极其大的,尤其对算力要求非常高,更别提返到原厂去重新训练的时间和经济成本。

也就导致在严谨内容场景下,一旦有内容和评价发生较大转变,TRansfoRMeR大模型学徒们往往要1-2个月去把数据清掉后,再重新训练后进行提交,客户一般很难接受。

这些toB实践中的真实反馈,让刘凡平意识到客户对模型立即更新的需求,这要求模型不仅具备实时学习的能力,同时学习之后不能胡说八道。

怀揣着“机器能否具有像人一样实时学习的能力”的思考,以及跟着客户真实需求走的大方向指引,同步学习这一解法,在RockAI逐步清晰。

相比较泛机器学习领