4月20日消息,Meta推出其80亿和700亿参数的Meta LlaMa 3开源大模型。该模型引入了改进推理等新功能和更多的模型尺寸,并采用全新标记器(TokenizeR),旨在提升编码语言效率并提高模型性能。

英特尔验证了LlaMa 3能够在包括英特尔至强处理器在内的AI产品组合上运行,并披露了即将发布的英特尔至强6性能核处理器(代号为GRanITe RAPIds)针对Meta LlaMa 3模型的推理性能。

英特尔至强处理器可以满足要求严苛的端到端AI工作负载的需求。每个核心均内置了AMX加速引擎,能够提供出色的AI推理和训练性能。至强处理器已被众多主流云服务商所采用。至强处理器在进行通用计算时,能够提供更低时延,并能同时处理多种工作负载。

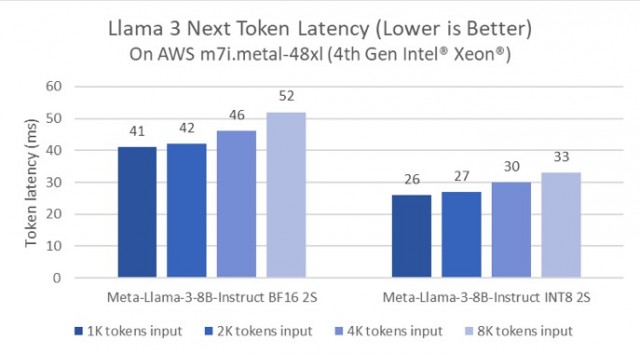

AWS实例上LlaMa 3的下一个Token延迟

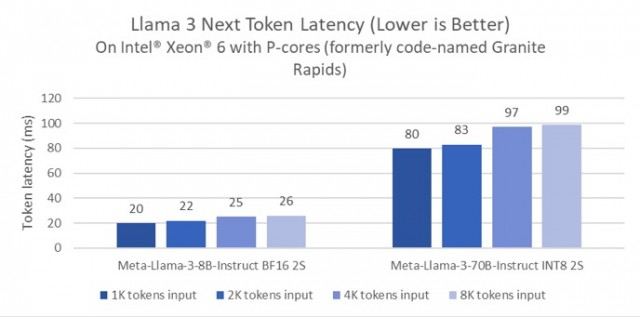

英特尔首次披露了即将发布的产品——英特尔至强6性能核处理器(代号为GRanITe RAPIds)针对Meta LlaMa 3的性能测试。与第四代至强处理器相比,英特尔至强6处理器在80亿参数的LlaMa 3推理模型的延迟降低了2倍,并且能够以低于100毫秒的Token延迟,在单个双路服务器上运行诸如700亿参数的LlaMa 3这种更大参数的推理模型。

基于英特尔至强6性能核处理器(代号GRanITe RAPIds)的LlaMa 3下一个Token延迟

考虑到LlaMa 3具备更高效的编码语言标记器(TokenizeR),测试采用了随机选择的ProMpt对LlaMa 3和LlaMa 2进行快速比较。在ProMpt相同的情况下,LlaMa 3所标记的Token数量相较LlaMa 2减少18%。即使80亿参数的LlaMa 3模型比70亿参数的LlaMa 2模型参数更高,在AWS M7i.Metal-48xl实例上运行BF16推理时,整体ProMpt的推理时延几乎相同。