连续两天,半夜爆出大消息。先是华为新机深夜上线,让芯片国产替代的步伐更进一步;次日晚,百度文心一言官宣向公众全面开放–两大劲爆消息直接点燃科技圈。

8月31日凌晨,百度官方公众账号即发布推文,称“文心一言向全社会开放”,用户可以在应用商店下载“文心一言APP”或登陆“文心一言官网”体验。包括百度文心一言在内,一共有8个企业/机构的大模型位列第一批名单,可以正式上线面向公众提供服务,值得注意的是,被看作文心一言竞争者的阿里通义千问、360智脑、讯飞星火等,不在首批获批名单中。

随后“文心一言APP”在各大应用商店冲上热榜,在苹果App Store上更是直接登顶免费榜榜首,成为当日热门应用,这无疑让百度再一次占得了先机。

此前,在获得备案审批之前,各家只能小范围内测,用户需要“排队”申请内测资格,由此大大限制了大模型在用户层面的推广,如今大模型备案获批和全面开放,大模型的步伐有望迈入下一阶段。

秉持着技术自主的理念,将资金大规模倾斜到自主技术研发的百度和华为,可以说是殊途同归,而软硬件领域的“双子星”联袂,共同推动技术投入走向“开花结果”。

技术坚守,换来厚积薄发

大模型在国内掀起新一代技术浪潮,迅速席卷了整个互联网,而百度在大模型赛道上的步伐一直领先。2019年第一个发布了文心大模型,2023年,大厂中最早推出大语言模型“文心一言”,如今又率先获批、得到认可,正式向全社会开放。

百度之所以快速踩在了大模型的全球性技术风口上,是建立在百度雄厚的技术基底之上。

早从2010年开始,百度就已经着手布局AI相关技术的研发,近十年来,累计研发投入超过 1400 亿元。其中2022 年研发费用高达 214.16 亿元,占百度核心收入比例达到 22.4%。与全球其他大厂相比,这些投入也是数一数二。

在高研发成本的持续投入下,这些年从最初探索深度学习等基础技术,到推动AI在互联网等场景试点落地,再到如今扎根千行百业、大力推进AI工业化大生产等,百度既完成了在芯片、框架、模型和应用四层构架对应的自研技术积累,具备了做AI基础设施供给者的前提条件,又成功引领了AI技术成果在产业层面的实践,降低了人工智能的开发和应用门槛。

这也使得百度无论在技术专利、技术产品还是技术应用上,都占据了领先地位。以专利来看,根据由国家工业信息安全发展研究中心、工信部电子知识产权中心发布的《中国人工智能专利技术分析报告(2022)》显示,百度AI专利申请量1.68万件,连续五年保持中国第一;专利授权量上,百度仍以5705件专利授权量位列第一。

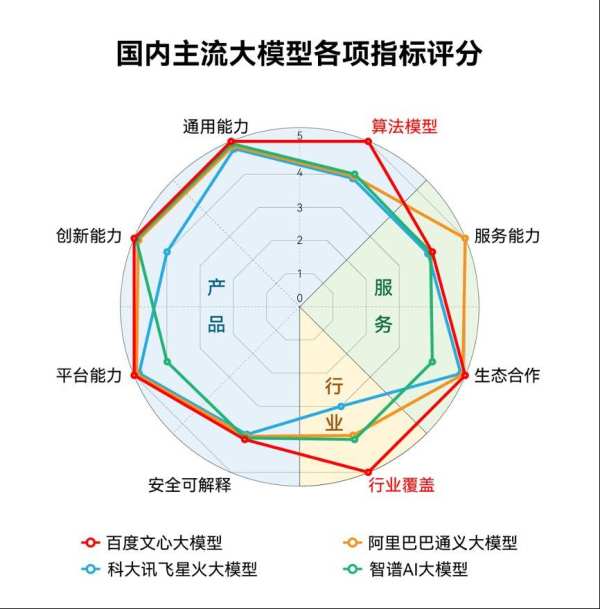

如IDC最新发布的《AI大模型技术能力评估报告,2023》,报告显示,百度文心大模型3.5拿下12项指标的7个满分,综合评分第一,算法模型第一,行业覆盖第一。其中算法模型是大模型能力最为核心的要素,百度文心大模型在这一维度获得了唯一的满分。

更令外界欣喜的是,从测评来看,百度文心一言大模型能力从5月至今不断提升,正在逐渐赶上国外大模型。

百度「AI大底座」的全栈能力,助力文心一言进化

31日凌晨全面开放后,百度文心一言APP迅速飙升至苹果商店免费榜榜首,成为首个登顶应用商店榜首的中文AI原生应用。

用户的反响,透露出他们对文心一言表现出的强劲进化能力的期待。自今年3月发布至今,文心一言快速成长,熟练掌握的创作体裁超过200个,内容丰富度是发布初期的1.6倍,思维链长度是初期的2.1倍,知识点覆盖达到初期的8.3倍。在一些公开测评中,文心大模型3.5版支持下的文心一言中文能力突出,甚至有超出GPT-4的表现。

这很大程度上得益于百度飞桨,百度拥有自研的深度学习平台飞桨,它有力支撑了大模型的高效训练和推理。通过飞桨端到端自适应混合并行训练技术以及压缩、推理、服务部署的协同优化,文心大模型训练速度达到原来的3倍,推理速度达到原来的30多倍。

飞桨和文心一言,一个是框架平台,一个是大模型,这两者之间正好处在人工智能技术体系里面很重要的两层,它们之间有很强的协同优化潜力,由此飞桨领先的训练技术,能够优化大模型的训练效率。

百度不单单在框架层和模型层拥有关键技术。进入人工智能时代,IT技术的技术栈发生了根本性变化,从过去三层转变为“芯片-框架-模型-应用”四层,百度则是全球为数不多、进行全栈布局的人工智能公司。从高端芯片昆仑芯,到飞桨深度学习框架,再到文心预训练大模型,及搜索、智能云、自动驾驶、小度等应用,各层都有领先业界的关键自研技术。

如框架层上,百度从2016年就开源了飞桨深度学习框架,目前这一框架已经集成了深度学习核心训练和推理框架、基础模型库、端到端开发套件等工具组件,在中国市场份额中排行第一。

全栈布局的优势在于,可以在技术栈的四层架构中,实现端到端优化,大幅提升效率,飞桨和文心一言的优化,就是最典型的例子。另外,芯片、框架、大模型和终端应用场景,也可以形成一个高效的反馈闭环,帮助大模型不断去调优迭代,越做越好。

比如文心一言与搜索、信息流等应用层的协同。百度的搜索服务,每天响应几十亿次真实的用户使用需求,每天进行1万亿次深度语义推理与匹配,能够提供最真实、最及时的反馈,从而倒逼大模型、深度学习框架和芯片的优化。相对地,文心一言应用于搜索,也将带来搜索的变革。

除了全栈自研的「AI 大底座」,百度智能云推出的两大AI工程平台–「AI 中台」和「百度百舸· AI 异构计算平台」,也分别在开发和资源层面进行提效,加速训练过程。这给文心一言的成长提供了最坚实的技术支撑,也成为其追赶国外大模型的底气。

核心能力升级,百度加速大模型落地时代到来

5月底举行的2023万象·百度移动生态大会上,百度搜索宣布“AI伙伴”开始内测。这款全能的“Al伙伴”能够听懂用户的任何问题,并用语音进行互动,还能帮助用户标记答案中的重点,提供权威的来源。在演示中,“Al伙伴”完整地提供了一篇人工智能大会主持词。

百度旗下各类用户侧产品正在利用大模型进行重构,而基于大模型基座和云平台进行开发生态的建设也在同步推进。前不久,百度承办的2023 WAVE SUMMIT上,推出了“超级助理”和“Comate X智能编程助手”。

理解、生成、逻辑和记忆,构成了一个人工智能或者通用人工智能系统最基本的能力,从文心一言在C端及B端应用上的表现来看,这四大核心能力正在快速提升,而背后展示出的则是百度在知识增强、检索增强、对话增强方面的关键技术能力和差异化优势。

庞大的知识图谱和搜索基础上对真实数据和用户需求的理解,是百度多年来构建技术护城河和打造内容生态的基础,因而作为百度自主研制的知识增强大语言模型,文心一言在知识增强和检索增强方面天然具有优势。

据悉,百度文心大模型拥有世界上最大规模知识图谱,包含50亿实体、5500 亿级事实,每天调用量超过400亿次。

在对话增强方面,百度深耕对话技术多年,前不久,王海峰带领团队完成的「知识与深度学习融合的通用对话技术及应用」成果,荣获了「2022 年度吴文俊人工智能科技进步奖特等奖」,这是该奖项设立以来颁发的首个特等奖。对话技术所涉及的记忆机制、上下文理解和对话规划能力,能够帮助文心一言实现更好的对话连贯性、合理性和逻辑性。

百度已经构建了面向中文、服务应用、富含知识的多样化训练数据,并建立起人类反馈、奖励模型和策略优化之间的飞轮机制,随着真实用户的反馈越来越多,文心一言的效果会越来越好,能力也越来越强。

而今,文心一言率先面向用户全面开放,也就说未来能获得更海量的真实世界中的人工反馈,这将进一步改进基础模型,助力文心一言加速迭代、提升能力。而且,对用户层面的放开,会刺激大模型竞争焦点转向应用层,激起应用开发的创造活力,基于文心一言的领先,百度未来或将率先带来杀手级应用,真正引领大模型进入落地时代。

这亦是用户想从这场技术性浪潮看到的,弯道超车,占领新一代技术变革的制高点。