编者按:我们和电脑之间的交流正在发生着转变,而深度学习也已经润物细无声地进入我们的生活,甚至在你意识到这一点之前,世界已经截然不同。

什么是人工智能?

- 人工智能

人工智能是一个广义概念,它可以应用到任何一种可以使计算机模拟人类智慧、使用逻辑算法、决策树、机器学习(包括深度学习)的技术中。

- 机器学习

它是人工智能的一个分支,包括能使机器根据经验完成任务的深度统计技术,机器学习包括了深度学习。

- 深度学习

深度学习是机器学习的一个分支,它包括允许软件自行完成任务的算法,例如语音和图像识别,通过多层神经网络系统传输给大数据。

深度学习可以改变任何一种工业,谷歌大脑项目的领导者 Jeff Dean 说:“计算机视觉一旦开始使用就会产生许多基本变化。”随后他又纠正说:“现在计算机已经打开了人们的新世界。”

曾经有一个假设是这样说的:当超级智能机器不需要人类的参与就可以完成许多事情的时候,那些低能的人类就要面临被淘汰的危险。难道现在是要证明这个假设了吗?

或许并不是。神经网络系统甚至比人类更善于模式识别,但是它们并不能推理。

2009 年发生了第一次变革。那年夏天微软的Lee邀请多伦多大学的神经网络大师 Geoffrey Hinton 来参观。根据他的研究,Lee 的团队研究了神经网络对于语音识别的应用。Lee 说:“对于结果我们很震惊,用第一个原型准确度提高了 30% 以上。”

2011 年,根据 Lee 的研究,微软将深度学习技术应用到了它的商业语音识别产品中。随后在2012年8月谷歌也应用了这项技术。

但是真正的转折点是在 2012 年 10 月,在意大利佛罗伦萨的一间工作室,斯坦福人工智能实验室的领导人、著名的年度 ImageNet 计算机视觉大赛创办人李飞飞宣布,两位 Hinton 的学生发明的软件能以比竞争者高达两倍的准确度识别物体。Hinton 说:“这是个引人注目的结果,这个结果说服了很多之前对此表示怀疑的人。”(在去年的一场深度学习超越人类的争论中。)

图像识别像是一个发令枪,它引发了一场新的聘用比赛。谷歌聘用 Hinton 和赢得比赛的那两名学生,Facebook 签约法国深度学习创新者 Yann LeCun,他是在二十世纪八十年代和九十年代都赢得了 ImageNet 比赛的算法先驱。而百度则聘用 Ng,他是斯坦福人工智能实验室的前领导人,他在 2010 年也领导了谷歌大脑计划的深度学习项目。

从那时起的挖人风波愈演愈烈,如今,微软的 Lee 说:“在这块领域里一场血腥的人才相争之战正在上演,顶级的头脑需求就像美国橄榄球联盟足球员那么多。”

68 岁的 Geoffrey Hinton 第一次听说神经网络是在1972年,那时他刚在爱丁堡大学开始他的人工智能毕业设计。本科在剑桥的时候已经学习了实验心理学,他对神经网络算法十分感兴趣,神经网络是软件构造基础,这种灵感来自于大脑中神经元的工作模式。那个时候神经网络没有那么受欢迎,大家都认为他们疯了,但是 Hinton 坚持干着。

神经网络展现了计算机学习的前景:像孩子学习那样从经验获得,而不是通过人类设计的程序发出的蹩脚的指令。他回忆说:“大多数人工智能从那时起都是由逻辑启发,但是有的人很晚才意识到逻辑这回事。两三岁的孩子没有逻辑,所以对于智能,神经网络似乎比逻辑能更好的应用。”(逻辑是 Hinton 的一个家庭交易,他出身科学世家,他是19世纪数学家 George Boole 的玄孙,在 Boolean 研究之后,逻辑和算法得以命名。)

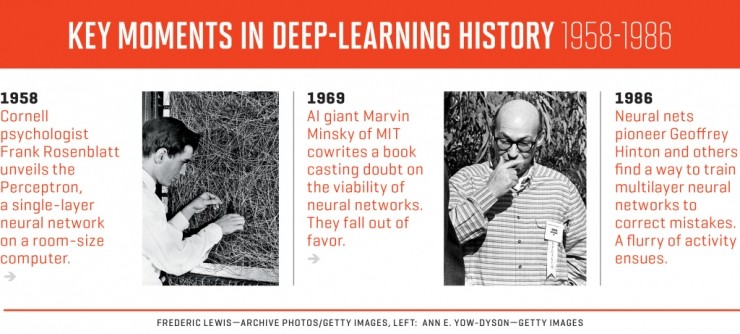

在 20 世纪 50 年代和 60 年代期间,神经万罗在计算机科学家中很盛行,在 1958 年,康奈尔大学研究心理学家Frank Rosenblatt在布法罗的实验室,在一个海军项目中,以神经网络构建了一个原型,他称之为Perceptron。他利用了一台充满整间屋子的穿孔卡片电脑,试验 50 次以后它可以辨别左右两边的卡片,《纽约时报》报道:海军认为现如今的电子计算机的雏形将来会听说读写、行走、繁殖、有存在意识。

Perceptron的软件由于限制,只有一层神经元,但是研究者认为将来会有多层或深层神经元网络。

Hinton 解释了这个理论。假设神经元网络在绘制摄影图像,比如说画一只鸟。“输入指令‘像素’然后第一层单元就会检测边缘,一边暗,另一边亮,第二层神经元会根据第一层的数据进行分析。”例如,某一个神经元会直接描绘鸟嘴的角度。

下一层会进行更复杂的立体基阵,比如许多边排列成一个圈。这时神经元可能对应出鸟的头部。更高级的神经元会检测在鸟头部附近的圆圈里反复出现并列的像鸟嘴的角度。它会检测那是不是鸟头。Hinton说道,更高级的神经元层会对应出更复杂的形态,直到绘制出我们所定义的“鸟”的形状。

然而,仅仅通过神经元层给出信息是不够的,我们需要知道最高层神经元是否得到了正确结果,如果没有的话,需要撤回信息确保低级神经元能够重新整合优化结构。于是深层学习就出现了。

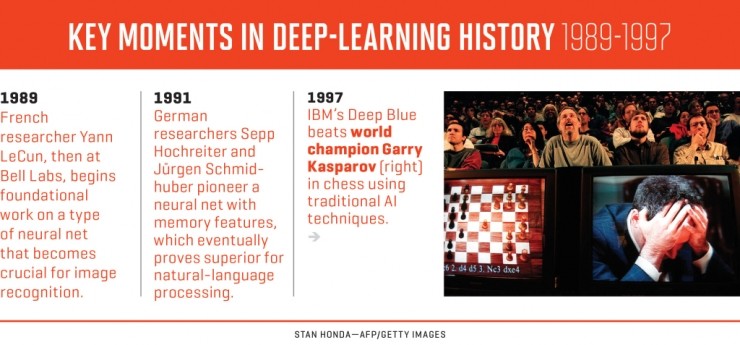

在 20 世纪80年代初期,Hinton在研究这个问题,法国的一位叫Yann LeCun 也在做相同的研究,他刚开始在巴黎进行他的毕业设计。LeCun 对 Hinton 1983 年的一篇阐述了多层神经元的文章产生质疑。“在那个时候,这篇文章没有很好地进行表述,因为在那个时期,你提到‘神经’和‘神经元’这样的词是很难发表文章的。”他回忆道,“于是他就以模糊不清的方式写了文章,审稿人才通过这篇文章,但是我对这篇文章很感兴趣。”二人在两年后相见,并就此展开研究。

1986 年,Hinton 和他的两位同事就利用算法解决错误相关问题发表了学术文章。“这篇文章是神经元第二次风波的基础。” LeCun 说,这再次燃起了他对此领域的兴趣。

跟随 Hinton 完成博士后工作以后,LeCun 在 1988 年去了美国电话电报公司的贝尔实验室,在这个地方,他完成了接下来十年的基础工作研究,这些研究至今仍在图像识别领域被沿用。 20 世纪 90 年代,根据 LeCun 的研究,贝尔实验室的子公司 NCR 生产了一种神经元支持的产品,这种产品广泛用于银行,它可以读取支票上的手写数字。同时,两名德国研究员也独立研究了不同类型的算法,20 年后的今天,这种算法在自然语言处理应用程序中十分重要。

然而在 20 世纪 90 年代中期,神经元算法再次衰落,被一种计算机时代更有效的机器学习工具所替代,这种状况持续了十年左右,直到计算能力增加了三到四个数量级,这时研究者发明了图形处理器加速器。