目前AI领域 的一大趋势是什么?没错,就是扩大数据集规模。然而最近Geogle ReseRach 的一篇论文,却认为对超大规模数据集进行整理的趋势,反而会阻碍有效开发人工智能系统。

数据规模真的越大越好?

算力和数据是人工智能两大主要驱动力。无论是计算机视觉,还是自然语言处理等AI系统似乎都离不开数据集。

在超大规模数据时代,数据和学习结果是这样的关系:

数据规模越大,AI模型越精准、高效。在大部分人眼里,这似乎是个不争的事实。

数据规模和模型精确度难道真的是呈现正相关关系吗?

最近,Geogle ReSeaRch 上发布的一篇论文,对这一普遍持有的观点,提出了质疑的呼声。

规模一大, “饱和”就无处不在!

这篇名为ExpolRing the liMITs of pRe-tRAIning Model 挑战了机器学习效果和数据关系的既有假设。经过试验得出的结论是:无论是通过扩大数据规模还是超参数来改进上游性能,下游可能会出现 “饱和”现象。

所谓饱和就是…..你懂的哈,就是没有梯度信号传入神经元,也无法到权重和数据,这样网络就很难以进行学习了。

文中还提到了一种极端的情况,上游和下游的性能是互相矛盾的 ,也就是说:要想获得更好的下游性能,可能得牺牲掉上游任务的精确度。

这一假设一旦得到验证,就意味着 “超大规模 “数据集,如最近发布的LAION-400M(包含4亿个文本/图像对),以及GPT-3神经语言引擎背后的数据(包含1750亿个参数),有可能受限于传统机器学习的架构和方法。庞大的数据量可能会使得下游任务饱和,降低了其泛化的能力。

其实呢,之前的假设也不是完全在 “胡言乱语”,只是要加上一个条件即:既定数据规模的超参数要在一个较为简单的线性函数关系中 , 且是一个固定的值。

考虑到有限的计算资源和经济成本等问题,先前的研究范围较小,让人们对数据集和有效AI系统间的关系产生了不全面的认知。原来以偏概全是通病!

事实上怎么可能有这么简单呢?

文章又反驳道 “先前关于论证数据规模有效性的研究,仅是在有限的范围进行的。 因而不能妄下定论。”

唱反调也得有依据!文章为什么会得出这样的结论呢?原来真相就在眼前!

上下游的关系不简单!

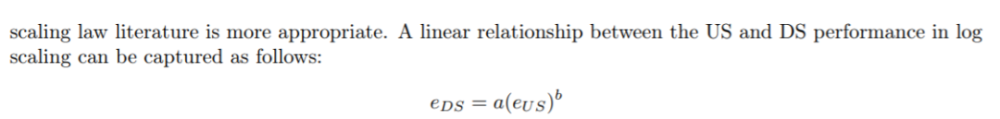

先前的研究是在线性函数的假设基础上,呈现出了对数关系。

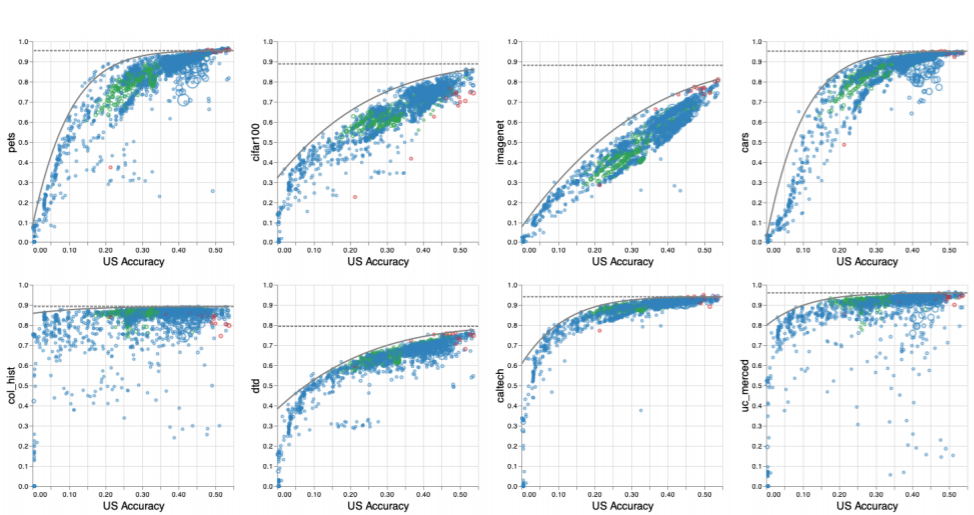

然而经过研究发现,情况是这样的

从图中可以发现,下游任务在某些点,会发生饱和。但这些 “饱和点”并不固定。因而文章推论,上下游之间的关系是非线性的。

数据、模型规模的扩大,倒是能提高上游性能。但是由于这种非线性关系的存在,提高上游的准确度的同时,下游准确度就不能够保证了。

预训练模型不能让人们 “一劳永逸”!

本文讨论了 “预训练 “的做法,这种措施旨在节省计算资源,减少从零开始训练大规模数据所需的时间。

预训练可以明显提高模型的鲁棒性和准确性。但新的论文表明,即使在相对较短的预训练模板中,但是考虑到特征的复杂性,预训练模型不适合于所有情况。如果研究人员继续依赖预训练模型,可能影响到最终结果的准确性。

论文最后提到,”我们不能期望找到适用于所有下游任务的预训练模型。”

规模有多大,就有多准确?

Geogle ReSeaRch 的研究结果对这一定论,勇敢说出了 “不”,的确让人们眼前一亮!是否会对整个AI研究领域,带来突破性的进展呢?也许会由此带动更多的相关研究,会不知不觉掀起另一波 “浪潮”?咱们走着瞧!