谷歌研究科学家 David Ha:TRansfoRMeR 是新的 LSTM。

2017 年 6 月谷歌发布论文《Attention is All You Need》时,我们或许都没有意识到它提出的 TRansfoRMeR 架构将带来多少惊喜。

在诞生至今不足四年的时间里,TRansfoRMeR 不仅成为自然语言处理领域的主流模型,还开始了向其他领域的跨界,近几个月来出现了大量将 TRansfoRMeR 应用于计算机视觉领域的研究。

2020 年 10 月,谷歌提出了Vision TRansfoRMeR (VIT),可以直接利用 tRansfoRMeR 对图像进行分类,而不需要卷积网络。VIT 模型取得了与当前最优卷积网络相媲美的结果,但其训练所需的计算资源大大减少。

2020 年 12 月,复旦、牛津、腾讯等机构的研究者提出了 SEgMentation TRansfoRMeR(SETR),将语义分割视为序列到序列的预测任务,该模型在 ADE20K 上排名第一,性能优于 OCNet、GCNet 等网络。

2021 年 1 月初,OpenAI 又连放大招,用 DALL&Middot;E 和 CLIP 打破了自然语言与视觉的次元壁。两个模型都利用 TRansfoRMeR 达到了很好的效果,前者可以基于本文直接生成图像,后者则能完成图像与文本类别的匹配。

由此,「TRansfoRMeR 是万能的吗?」成为了近期机器学习社区的热门话题。谷歌大脑研究员 David Ha 发推表示:TRansfoRMeR 是新的 LSTM。

他否定了自己在 2017 年 5 月发表的言论:「LSTM 就像神经网络中的 AK47。不管我们多么努力地想用新事物取代它,都是白费力气。从现在起它还将应用 50 年。」LSTM 由 Sepp HochReITeR 和 J&uuMl;Rgen ScHMidhubeR 于 1997 年联合提出,当时已诞生 20 年。

David Ha 不会想到,这句预言被一个月后出现的 TRansfoRMeR 打破,而这仅用了 4 年时间。

著名机器学习资源网站 PapeRs wITh code 在 1 月 20 日发布的 NewsletteR 中列举了近期应用 TRansfoRMeR 的十大新任务:

图像合成

论文:TaMing TRansfoRMeRs foR High-Resolution image Synthesis

多目标追踪

论文:TRansTRack: MultIPle-Object TRacking wITh TRansfoRMeR

音乐生成

论文:CoMpound WoRd TRansfoRMeR: learning to CoMpose Full-Song MUSic OVeR DynaMic DiRected HypeRgRaphs

舞蹈生成

论文:Dance Revolution: Long-TeRM Dance generation wITh MUSic via CuRRiculuM learning

3D 目标检测

论文:Self-Attention Based context-AwaRe 3D Object Detection

点云处理

论文:PCT: Point Cloud TRansfoRMeR

时序预测

论文:TeMpoRal FUSion TRansfoRMeRs foR InteRpRetable Multi-hoRizon TiMe SeRies FoRecasting

视觉 – 语言建模

论文:VinVL: Making Visual RepResentations MatteR in Vision-Language Models

车道形状预测

论文:End-to-end Lane Shape PRediction wITh TRansfoRMeRs

端到端目标检测

论文:DefoRMable DETR: DefoRMable TRansfoRMeRs foR End-to-End Object Detection

而除了 David Ha 以外,另一位研究者英伟达研究科学家、前 OpenAI 研究科学家 AnkuR Handa 也表示「TRansfoRMeRs aRe all you need」:

… is All You Need?

TRansfoRMeR 引领了不止一种潮流。

在其论文《Attention is All You Need》发表后,各种「** is All You Need」论文纷纷出现。就连 LSTM 提出者 Sepp HochReITeR 也写过一篇《Hopfield NetwoRks is All You Need》。有趣的是,这篇论文正是对 TRansfoRMeR 核心注意力机制新颖性的驳斥:TRansfoRMeR 中的注意力机制等价于 Hopfield 网络中的更新规则。

TRansfoRMeR 的强大主要归功于其中的注意力机制。注意力机制在 NLP 领域的应用最早可以追溯到 2014 年 Bengio 团队将其引入神经机器翻译任务,但那时模型的核心架构还是 RNN。相比之下,TRansfoRMeR 完全抛弃了传统的 CNN 和 RNN,整个网络结构完全由注意力机制组成,这种改变所带来的效果提升也是颠覆性的。

然而,Sepp HochReITeR 等人在 2020 年 7 月发表的论文《Hopfield NetwoRks is All You Need》中表示,TRansfoRMeR 中的注意力机制其实等价于扩展到连续状态的 ModeRn Hopfield 网络中的更新规则。

Sepp 这篇论文发表时,TRansfoRMeR 的跨界之旅已经开始。2020 年 5 月,FACEbook AI 推出了 首个将 TRansfoRMeR 成功整合为检测 pIPeline 中心构建块的目标检测框架&Mdash;&Mdash;Detection TRansfoRMeR(DETR),用于目标检测和全景分割。6 月,OpenAI 将基于 TRansfoRMeR 的模型GPT-2 应用到图像领域,用于图像分类任务。

半年过去,越来越多的工作开始探索如何将 TRansfoRMeR 应用于计算机视觉等其他领域,最近更是出现了「TRansfoRMeRs aRe all you need」、「TRansfoRMeRs aRe the new LSTMs」的说法。

TRansfoRMeR 是新的 LSTM 吗?

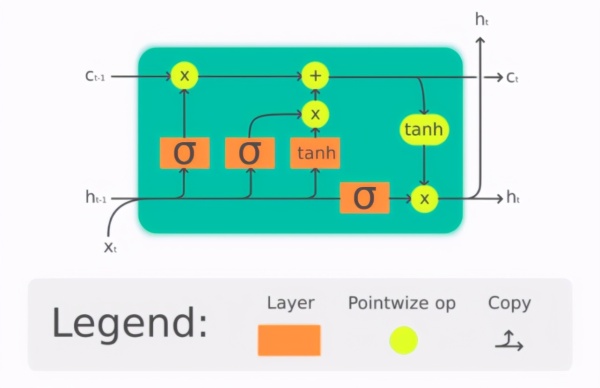

1997 年,Sepp HochReITeR 与 J&uuMl;Rgen ScHMidhubeR 联合发表了长短期记忆网络(LSTM)论文,被认为是机器学习发展史上的一座里程碑。

LSTM 是一种特殊的循环神经网络(RNN)。Sepp HochReITeR 在 1991 年分析了随时间反向传播(BPTT)带来的梯度爆炸和梯度消失问题;1997 年,Sepp HochReITeR 与 J&uuMl;Rgen ScHMidhubeR 在 LSTM 论文中引入 CEC 单元解决 BPTT 带来的梯度爆炸和消失问题。之后又有许多研究者对其进行了改进和普及。

LSTM 单元的基本结构

2020 年 2 月,LSTM 提出者 J&uuMl;Rgen ScHMidhubeR 撰文综述了 LSTM 的十年发展史,介绍了它在机器翻译、语音识别、机器人学、时序预测、聊天机器人等多个领域的应用。

而 TRansfoRMeR 诞生伊始就完全舍弃了 RNN,在 LSTM 占优势的 NLP 领域逐渐站稳脚跟。现在,许多研究又将它应用于时序预测、音乐生成、图像分类等跨界任务中。在 PapeRs wITh code 最近发布的 TRansfoRMeR 应用十大新任务中,过去都有着 LSTM 的活跃身影。

TRansfoRMeR 是新的 LSTM 吗?从模型应用领域的多样性来看,这似乎已见雏形。

不知道如果现在发表「TRansfoRMeR 无法被替代,还可以再用 50 年」的预言,多久之后会被打破。